Data Science Abschlussprojekte Gruppe #24

von Ekaterina Butyugina

Wir möchten uns einen Moment Zeit nehmen, um allen Studierenden, die sich uns im November angeschlossen und alles gegeben haben, um den Kurs und die Abschlussprojekte durchzuziehen, ein grosses Lob auszusprechen.

In nur drei kurzen Monaten haben die unglaublichen Data Science-Enthusiasten aus der Gruppe #24 in Zürich, zusammen mit der beeindruckenden vierten Kohorte aus München, eine vielfältige Palette herausfordernder Projekte bewundernswert gemeistert. Ihre herausragenden Fähigkeiten und ihre unerschütterliche Hingabe waren voll und ganz zu sehen. Dieses Mal spielte HP, die uns exklusive Z by HP Workstations zur Verfügung stellten, eine bedeutende Rolle beim Erfolg der Studierenden.

Wir ermutigen dich, aus erster Hand die transformative Kraft der Datenwissenschaft zu erleben, da sie Grenzen verschieben, Einsichten aufdecken und bedeutungsvollen Einfluss nehmen.

Syrus hilft Herstellern von Industriemaschinen, die finanzielle Leistung durch wertbasierte Preisgestaltung zu verbessern. Sie verwalten eine grosse Datenbank mit Ersatzteilen aus verschiedenen Branchen, und ein wichtiger Schritt beinhaltet das Gruppieren ähnlicher Teile. Derzeit wird dieser Prozess manuell durchgeführt, und Syrus suchte nach Automatisierungslösungen.

Um das Gruppieren ähnlicher Ersatzteile aus einer grossen Datenbank zu automatisieren, erhielten Ria, Naveen und Pedro den Datensatz, der Artikelnamen auf Deutsch und Englisch umfasste, mit Bildern für etwa 55% der Teile. Die Bilder hatten unterschiedliche Hintergründe, Grössen und konnten unerwünschte Elemente wie Lineale oder Massbänder enthalten. Siehe das Bild unten:

Abbildung 1. Datenbeispiel

Der Arbeitsablauf des Projekts umfasste die folgenden Schritte:

Abbildung 2. Ergebnisse

Für die Zukunft planen Ria, Naveen und Pedro, die Lösung in den bestehenden Workflow von Syrus zu integrieren und weiterhin den Einfluss der Bildmenge pro Gruppe auf die Clustering-Ergebnisse zu untersuchen.

Dieses Projekt automatisierte erfolgreich den Prozess der Ersatzteilgruppierung für Syrus und verbesserte die Effizienz und Genauigkeit. Obwohl Herausforderungen bei der Integration und zukünftigen Leistungsschwankungen bestehen bleiben, demonstriert das Projekt das Potenzial der Kombination von Text- und Bilddaten für effektives Teile-Clustering.

Syntheticus ist ein Startup, das mit sicheren synthetischen Daten das volle Potenzial der KI erschliesst.

Syntheticus hilft Unternehmen dabei, mit GenAI qualitativ hochwertige und konforme Datenmuster in grossem Massstab zu generieren. Tauche ein in das hochmoderne Reich der synthetischen Daten, während wir uns auf eine Reise begeben, um die Fähigkeiten verschiedener Algorithmen zur Datengenerierung zu bewerten. Qualitativ hochwertige synthetische Daten sind von zentraler Bedeutung, da sie die komplexen Muster echter Datensätze widerspiegeln und gleichzeitig strenge Datenschutzstandards einhalten. Aber was genau macht gute synthetische Daten aus, und welche Herausforderungen sind damit verbunden?

Abbildung 1. Herausforderungen

Es gibt drei Hauptkomponenten. Erstens, die Treue: Repräsentieren die synthetischen Daten die realen Daten und haben sie ihre ursprünglichen Eigenschaften wie Verteilungen und Korrelationen beibehalten? Zweitens, die Skalierbarkeit: Ist es möglich, die Menge der generierten Daten treu und privat zu erhöhen? Zu guter Letzt, die Privatsphäre: Sind die synthetischen Daten anfällig für Datenlecks?

Ihr Ziel war es, den proprietären Algorithmus von Syntheticus zu benchmarken und ihn mit anderen konkurrierenden Syntheseplattformen zu vergleichen: YData (GMM) und SDV (HMA). Um diese Algorithmen im herausfordernden Kontext der Multi-Tabellen-Synthese zu bewerten, griffen sie auf einen offen verfügbaren Finanzdatensatz zurück, der aus 8 Tabellen (22k Zeilen) besteht, mit komplexen Verbindungen zwischen den Tabellen sowie verschiedenen kategorischen und numerischen Attributen.

Ihr Ansatz beinhaltete eine sorgfältige Erkundung verschiedener Kombinationen der 8 Tabellen, wobei jedes Mal die Algorithmen von Syntheticus, YData und SDV verwendet wurden, um synthetische Daten zu generieren. Durch systematische Experimente strebten sie danach, die Treue, Skalierbarkeit und Privatsphäre jedes Algorithmus umfassend zu bewerten.

Abbildung 2. Ergebnisse

Syntheticus zeigte eine gute Treue, dicht gefolgt von YData, während SDV deutlich schlechter abschnitt, gemessen an verschiedenen Metriken. Die Skalierbarkeitsanalyse bestätigte erneut Syntheticus als den stärksten Kandidaten, der konstant hohe Treue-Scores über verschiedene Mengen an Tabellen hinweg beibehielt. Im Gegensatz dazu zeigten SDV und YData einen Rückgang in der Leistung, je mehr Tabellen hinzukamen, was die überlegene Skalierbarkeit von Syntheticus weiter unterstreicht. Schliesslich wies Syntheticus eine ausgewogene Leistung über drei Datenschutzmetriken auf, was seine Effektivität in der treuen Reproduktion der Originaldaten bei gleichzeitigem Erhalt eines akzeptablen Datenschutzniveaus während der Synthese zeigt.

Insgesamt hat sich Syntheticus als die optimale Wahl für die Generierung synthetischer Daten gegenüber den zwei gewählten Konkurrenten herausgestellt und überzeugte durch Robustheit in allen wichtigen Leistungsmerkmalen. Blickend auf die Zukunft, empfehlen wir dir, die Nützlichkeit synthetischer Daten für nachgelagerte Anwendungsfälle im maschinellen Lernen weiter zu erforschen und Techniken der differentiellen Privatsphäre einzubeziehen, um den Datenschutz zu verbessern.

Ohne Zweifel werden synthetische Daten als entscheidender Katalysator für die Weiterentwicklung zukünftiger Algorithmen des maschinellen Lernens dienen, besonders in Szenarien, die sensible Daten (wie im Finanz- und Gesundheitswesen) oder Situationen mit Datenseltenheit, hohen Kosten und sogar bei grossen Sprachmodellen betreffen. Lass Syntheticus einen integralen Teil dieser transformativen Reise werden!

Nestlé, ein weltweit führender Anbieter von hochwertigen Lebensmitteln und Getränken, hat kürzlich eine bahnbrechende Kaffeemaschine auf den Markt gebracht, die das Brauerlebnis revolutionieren soll. Die Erfassung der Kundenreaktionen auf diese Innovation erwies sich jedoch als komplexe Herausforderung. Die traditionelle Methode, manuell nur 20 Bewertungen gleichzeitig zu analysieren, führte zu langsamen Verarbeitungszeiten, begrenzter Datenerfassung und oberflächlichen Einblicken.

Um dies zu beheben, wurde ein Projekt ins Leben gerufen, um eine automatisierte Datenanalyse-Pipeline zu entwickeln, die in der Lage ist, innerhalb von Minuten Hunderte von Bewertungen zu verarbeiten und so ein tieferes Verständnis der Kundenmeinungen zu erschliessen. Der Ansatz kombinierte Web-Scraping und API-Integrationen, um Bewertungen von 10 verschiedenen Plattformen in zwei Ländern zu sammeln, was zu einem Gesamt von 357 Bewertungen führte. Diese wurden dann vorverarbeitet und in eine gemeinsame Sprache übersetzt. Zusätzlich wurde ein „Zuverlässigkeitsdetektor für Bewertungen“ entwickelt, um illegitime Bewertungen auszusortieren, die 17 % der Gesamtbewertungen ausmachten.

Das Team, bestehend aus Elina, Danielle, Alexandra und Vahid, verfeinerte den Datensatz weiter, indem es zwei Methoden zur Erkennung von Duplikaten einsetzte: eine vorläufige Überprüfung basierend auf Metadaten und eine gründlichere Überprüfung auf hochgradig ähnliche Inhalte, bei denen eine Übereinstimmung von 70 % oder mehr festgestellt wurde. Dieser sorgfältige Prozess resultierte in einem sauberen und zuverlässigen Datensatz von 298 einzigartigen Bewertungen.

Mit Hilfe der natürlichen Sprachverarbeitung (NLP) extrahierte das Team nuancierte Einsichten aus den gesammelten Bewertungen. Eine erste Sentimentanalyse ergab eine überwiegend positive Stimmung unter den Kunden, ein vielversprechender Indikator für die Aufnahme des Produkts. Die Analyse ging tiefer und identifizierte spezifische Vor- und Nachteile, die in den Bewertungen erwähnt wurden.

Um die Rohdaten aufzupolieren und bedeutungsvolle Themen herauszudestillieren, setzte das Team grosse Sprachmodelle (LLMs) ein. Diese anspruchsvolle Analyse generierte 13 Schlüsselthemen und bot ein umfassendes Verständnis der Kundenpräferenzen sowie Einblicke in die Auswirkungen des Produkts.

Für diejenigen, die ein ausgeprägtes Interesse an den technischen Details hinter diesem innovativen Ansatz haben, bietet das folgende Unterkapitel einen tieferen Einblick in die Methoden und Technologien, die vom Team eingesetzt wurden. Dieses Projekt demonstriert nicht nur das Potenzial der Kombination fortschrittlicher Datenanalysetechniken, sondern unterstreicht auch Nestlés Engagement, Kundenbedürfnisse durch Innovation zu verstehen und zu erfüllen.

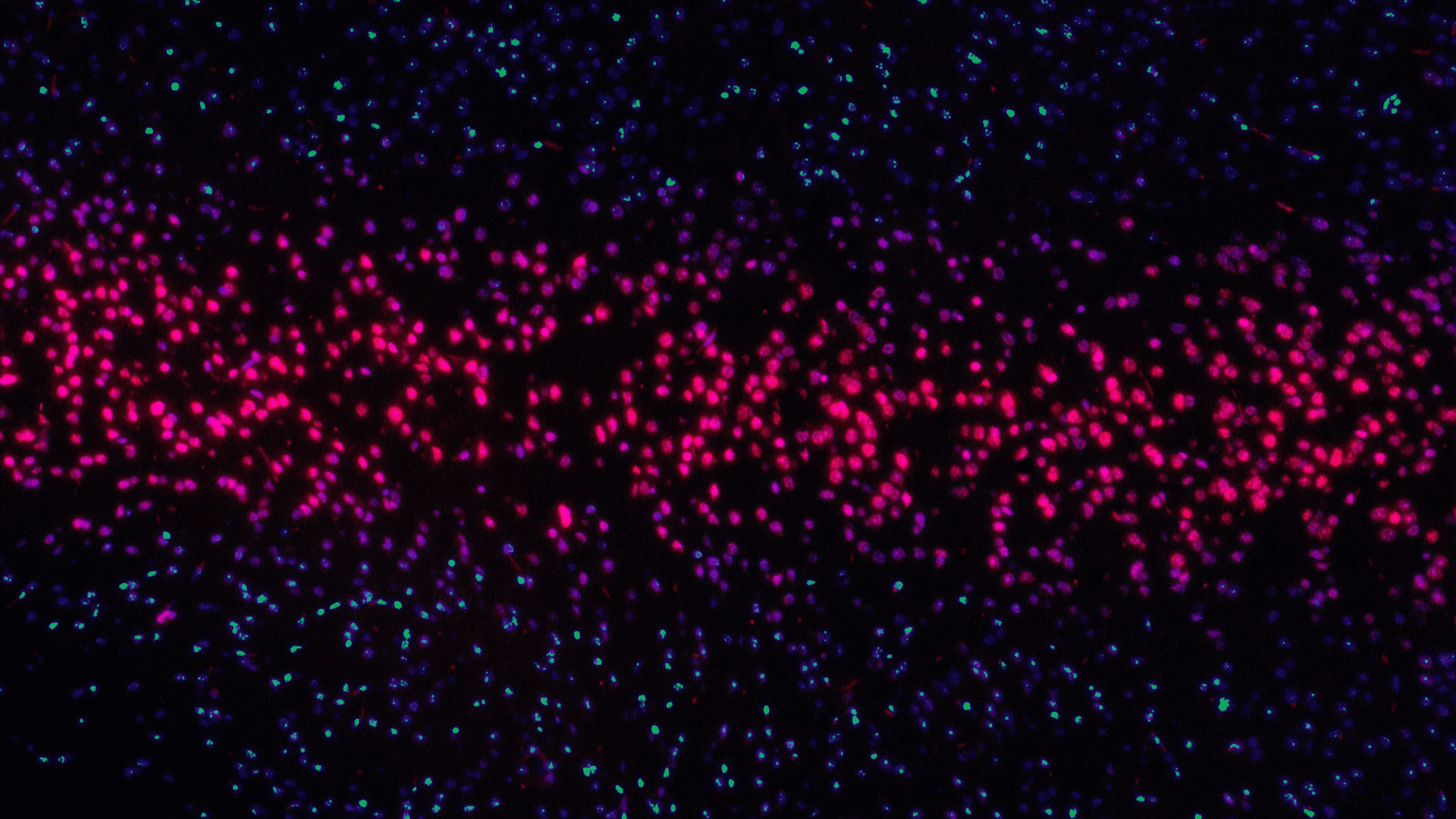

Abbildung 1: Themencluster-Visualisierung, die Themen mit zugehörigen Dokumenten zeigt

Die Analysepipeline besteht aus einer Mischung aus dem GPT 3.5-Modell und BERTopic. BERTopic nutzt Transformatoren und c-TF-IDF, um dichte Cluster ähnlicher Dokumente zu erzeugen und die Interpretation von Themen zu erleichtern, indem wichtige Begriffe in ihren Beschreibungen beibehalten werden.

Analyseblöcke:

Als letzten Schritt erstellte das Team eine Streamlit-App, mit der man seine Ergebnisse erkunden kann:

Laut aktuellen E-Commerce-Statistiken ist für 93 % der Verbraucher das Erscheinungsbild der wichtigste Faktor bei der Kaufentscheidung, was unterstreicht, dass das Kundenerlebnis für den Erfolg von BestSecret entscheidend ist. BestSecret ist eine Online-Shopping-Community, die nur für Mitglieder zugänglich ist und Premium- und Luxusmarken zu exklusiven Preisen anbietet.

Der Schwerpunkt des Projekts lag auf der Klassifizierung aller Produktbilder nach ihrem Typ, wobei das Team Erkenntnisse darüber gewinnen wollte, welche Teile der Bilder die Entscheidung des Klassifizierungsmodells beeinflussen, um die Genauigkeit und den Einblick in bildbasierte Empfehlungen zu verbessern. BestSecret stellte die Produktbilder für 4 verschiedene Kategorien zur Verfügung: Kleidung, Schuhe, Unterwäsche und Taschen. Jede Kategorie ist in fünf Klassen unterteilt. Die Bekleidungskategorie umfasst beispielsweise das Aussehen des Models, Vorder- und Rückansichten, Geisterbilder und gezoomte Details.

Abbildung 1: Daten

Zunächst bereinigten Anurag, Faezeh und Tschimegma die Daten und bereiteten verschiedene Datensätze für das Modelltraining vor. Das Team trainierte mehrere Modelle, darunter ein CNN-Basismodell, ResNet50, EfficientNetB0 und InceptionNet-V3. Von diesen Modellen lieferte ResNet50 die besten Ergebnisse.

Abbildung 2: Ergebnisse

Anschliessend wurde eine Streamlit-App entwickelt, mit der die Leistung des Modells untersucht werden kann und die Metriken wie Genauigkeit, Klassifizierungsberichte, Konfusionsmatrizen und die Anzahl der falsch klassifizierten Bilder für jede Kategorie anzeigt.

Um das Problem der Fehlklassifizierungen zu lösen, implementierte das Team Grad-CAM für die falsch klassifizierten Bilder. Dieses Tool ist von unschätzbarem Wert, da es verdeutlicht, auf welche Bereiche eines Bildes sich ein neuronales Faltungsnetzwerk (CNN) konzentriert, wenn es eine Vorhersage trifft.

Zusammenfassend lässt sich sagen, dass die Umstellung von der manuellen auf die automatische Klassifizierung die Genauigkeit deutlich verbessert hat, und zwar von etwa 90 % auf bis zu 97 %, während gleichzeitig der manuelle Aufwand minimiert werden konnte. Das System wird durch die Integration von End-to-End-Beschriftungsfunktionen weiter verfeinert werden.

Der nächste Schritt besteht darin, generative KI einzusetzen, um aus der Vorderansicht eines Artikels Bilder anderer Ansichten zu erstellen, was die Tür zu fortschrittlicheren und effizienteren Bildverarbeitungsfunktionen öffnet.

Skifahrer:innen erleben zunehmend, wie ihr Sport durch Daten eine neue Dimension erhält. Der Einsatz modernster Technologien ermöglicht es, einen Wintersporttag durch detaillierte Analysen der unterschiedlichen Aktivitäten zu bereichern.

Abbildung 1: AlpineSync App Screenshot

Die Zukunftsvision: Die Integration von Kartierungsfunktionen mit Google Maps APIs und die kontinuierliche Verbesserung der Modelle sind weiterhin zentrale Ziele. Nächste Schritte beinhalten:

Für diejenigen, die von diesen Geschichten inspiriert sind und ihre eigene Reise in der Datenwissenschaft beginnen möchten, freuen wir uns, unseren bevorstehenden Bootcamp anzukündigen. Erfahre mehr über unser Programm und wie du der nächsten Generation von Datenwissenschafts-Innovatoren beitreten kannst auf Constructor Academy.

In nur drei kurzen Monaten haben die unglaublichen Data Science-Enthusiasten aus der Gruppe #24 in Zürich, zusammen mit der beeindruckenden vierten Kohorte aus München, eine vielfältige Palette herausfordernder Projekte bewundernswert gemeistert. Ihre herausragenden Fähigkeiten und ihre unerschütterliche Hingabe waren voll und ganz zu sehen. Dieses Mal spielte HP, die uns exklusive Z by HP Workstations zur Verfügung stellten, eine bedeutende Rolle beim Erfolg der Studierenden.

Wir ermutigen dich, aus erster Hand die transformative Kraft der Datenwissenschaft zu erleben, da sie Grenzen verschieben, Einsichten aufdecken und bedeutungsvollen Einfluss nehmen.

Cluster-Konstruktor: Bild- und textbasiertes Clustering für industrielle Maschinenteile

Studenten: Maria Salfer, Naveen Chand Dugar, Pedro IglesiasSyrus hilft Herstellern von Industriemaschinen, die finanzielle Leistung durch wertbasierte Preisgestaltung zu verbessern. Sie verwalten eine grosse Datenbank mit Ersatzteilen aus verschiedenen Branchen, und ein wichtiger Schritt beinhaltet das Gruppieren ähnlicher Teile. Derzeit wird dieser Prozess manuell durchgeführt, und Syrus suchte nach Automatisierungslösungen.

Um das Gruppieren ähnlicher Ersatzteile aus einer grossen Datenbank zu automatisieren, erhielten Ria, Naveen und Pedro den Datensatz, der Artikelnamen auf Deutsch und Englisch umfasste, mit Bildern für etwa 55% der Teile. Die Bilder hatten unterschiedliche Hintergründe, Grössen und konnten unerwünschte Elemente wie Lineale oder Massbänder enthalten. Siehe das Bild unten:

Abbildung 1. Datenbeispiel

Der Arbeitsablauf des Projekts umfasste die folgenden Schritte:

- Datenvorverarbeitung:

- Entfernen von Artikeln mit fehlenden Namen.

- Fehlende Namen mit entsprechenden Namen in der anderen Sprache oder durch manuelle Eingriffe ergänzen.

- Anwendung von Segmentierung (LangSAM), um unerwünschte Elemente aus den Bildern zu entfernen.

- Merkmalsextraktion:

- Textdaten: Verwendung verschiedener Techniken der natürlichen Sprachverarbeitung wie Bag-of-Words, TF-IDF und Satztransformatoren, um Informationen aus Artikelnamen zu extrahieren.

- Bilddaten: Verwendung von Convolutional Neural Networks (ResNet50, VGG16) für die Merkmalsextraktion, auch mit Feinabstimmung auf gegebenen Bildern.

- Clustering:

- Clustern von Teilen basierend auf:

- Nur Textmerkmalen

- Nur Bildmerkmalen

- Kombinierten Merkmalen (Text und Bild)

- Verwendung von k-means sowie eines dichtebasierten Clustering-Algorithmus, DBSCAN, und Entfernung von datenpunkten mit Rauschen für optimale Ergebnisse.

- Clustern von Teilen basierend auf:

Abbildung 2. Ergebnisse

Für die Zukunft planen Ria, Naveen und Pedro, die Lösung in den bestehenden Workflow von Syrus zu integrieren und weiterhin den Einfluss der Bildmenge pro Gruppe auf die Clustering-Ergebnisse zu untersuchen.

Dieses Projekt automatisierte erfolgreich den Prozess der Ersatzteilgruppierung für Syrus und verbesserte die Effizienz und Genauigkeit. Obwohl Herausforderungen bei der Integration und zukünftigen Leistungsschwankungen bestehen bleiben, demonstriert das Projekt das Potenzial der Kombination von Text- und Bilddaten für effektives Teile-Clustering.

Algorithmische Erzeugung synthetischer Daten: Erforschung von Authentizität, Datenschutz und Skalierbarkeit

Studenten: Dàniel Kàroly, Justin Villard, Thomas VongSyntheticus ist ein Startup, das mit sicheren synthetischen Daten das volle Potenzial der KI erschliesst.

Syntheticus hilft Unternehmen dabei, mit GenAI qualitativ hochwertige und konforme Datenmuster in grossem Massstab zu generieren. Tauche ein in das hochmoderne Reich der synthetischen Daten, während wir uns auf eine Reise begeben, um die Fähigkeiten verschiedener Algorithmen zur Datengenerierung zu bewerten. Qualitativ hochwertige synthetische Daten sind von zentraler Bedeutung, da sie die komplexen Muster echter Datensätze widerspiegeln und gleichzeitig strenge Datenschutzstandards einhalten. Aber was genau macht gute synthetische Daten aus, und welche Herausforderungen sind damit verbunden?

Abbildung 1. Herausforderungen

Es gibt drei Hauptkomponenten. Erstens, die Treue: Repräsentieren die synthetischen Daten die realen Daten und haben sie ihre ursprünglichen Eigenschaften wie Verteilungen und Korrelationen beibehalten? Zweitens, die Skalierbarkeit: Ist es möglich, die Menge der generierten Daten treu und privat zu erhöhen? Zu guter Letzt, die Privatsphäre: Sind die synthetischen Daten anfällig für Datenlecks?

Ihr Ziel war es, den proprietären Algorithmus von Syntheticus zu benchmarken und ihn mit anderen konkurrierenden Syntheseplattformen zu vergleichen: YData (GMM) und SDV (HMA). Um diese Algorithmen im herausfordernden Kontext der Multi-Tabellen-Synthese zu bewerten, griffen sie auf einen offen verfügbaren Finanzdatensatz zurück, der aus 8 Tabellen (22k Zeilen) besteht, mit komplexen Verbindungen zwischen den Tabellen sowie verschiedenen kategorischen und numerischen Attributen.

Ihr Ansatz beinhaltete eine sorgfältige Erkundung verschiedener Kombinationen der 8 Tabellen, wobei jedes Mal die Algorithmen von Syntheticus, YData und SDV verwendet wurden, um synthetische Daten zu generieren. Durch systematische Experimente strebten sie danach, die Treue, Skalierbarkeit und Privatsphäre jedes Algorithmus umfassend zu bewerten.

Abbildung 2. Ergebnisse

Syntheticus zeigte eine gute Treue, dicht gefolgt von YData, während SDV deutlich schlechter abschnitt, gemessen an verschiedenen Metriken. Die Skalierbarkeitsanalyse bestätigte erneut Syntheticus als den stärksten Kandidaten, der konstant hohe Treue-Scores über verschiedene Mengen an Tabellen hinweg beibehielt. Im Gegensatz dazu zeigten SDV und YData einen Rückgang in der Leistung, je mehr Tabellen hinzukamen, was die überlegene Skalierbarkeit von Syntheticus weiter unterstreicht. Schliesslich wies Syntheticus eine ausgewogene Leistung über drei Datenschutzmetriken auf, was seine Effektivität in der treuen Reproduktion der Originaldaten bei gleichzeitigem Erhalt eines akzeptablen Datenschutzniveaus während der Synthese zeigt.

Insgesamt hat sich Syntheticus als die optimale Wahl für die Generierung synthetischer Daten gegenüber den zwei gewählten Konkurrenten herausgestellt und überzeugte durch Robustheit in allen wichtigen Leistungsmerkmalen. Blickend auf die Zukunft, empfehlen wir dir, die Nützlichkeit synthetischer Daten für nachgelagerte Anwendungsfälle im maschinellen Lernen weiter zu erforschen und Techniken der differentiellen Privatsphäre einzubeziehen, um den Datenschutz zu verbessern.

Ohne Zweifel werden synthetische Daten als entscheidender Katalysator für die Weiterentwicklung zukünftiger Algorithmen des maschinellen Lernens dienen, besonders in Szenarien, die sensible Daten (wie im Finanz- und Gesundheitswesen) oder Situationen mit Datenseltenheit, hohen Kosten und sogar bei grossen Sprachmodellen betreffen. Lass Syntheticus einen integralen Teil dieser transformativen Reise werden!

Kundengedanken: Von Bewertungen zu Empfehlungen für Nestlé-Kaffeemaschinen

Studenten: Elina Vigand, Danielle Lott, Alexandra Ciobîcă, Vahid MamduhiNestlé, ein weltweit führender Anbieter von hochwertigen Lebensmitteln und Getränken, hat kürzlich eine bahnbrechende Kaffeemaschine auf den Markt gebracht, die das Brauerlebnis revolutionieren soll. Die Erfassung der Kundenreaktionen auf diese Innovation erwies sich jedoch als komplexe Herausforderung. Die traditionelle Methode, manuell nur 20 Bewertungen gleichzeitig zu analysieren, führte zu langsamen Verarbeitungszeiten, begrenzter Datenerfassung und oberflächlichen Einblicken.

Um dies zu beheben, wurde ein Projekt ins Leben gerufen, um eine automatisierte Datenanalyse-Pipeline zu entwickeln, die in der Lage ist, innerhalb von Minuten Hunderte von Bewertungen zu verarbeiten und so ein tieferes Verständnis der Kundenmeinungen zu erschliessen. Der Ansatz kombinierte Web-Scraping und API-Integrationen, um Bewertungen von 10 verschiedenen Plattformen in zwei Ländern zu sammeln, was zu einem Gesamt von 357 Bewertungen führte. Diese wurden dann vorverarbeitet und in eine gemeinsame Sprache übersetzt. Zusätzlich wurde ein „Zuverlässigkeitsdetektor für Bewertungen“ entwickelt, um illegitime Bewertungen auszusortieren, die 17 % der Gesamtbewertungen ausmachten.

Das Team, bestehend aus Elina, Danielle, Alexandra und Vahid, verfeinerte den Datensatz weiter, indem es zwei Methoden zur Erkennung von Duplikaten einsetzte: eine vorläufige Überprüfung basierend auf Metadaten und eine gründlichere Überprüfung auf hochgradig ähnliche Inhalte, bei denen eine Übereinstimmung von 70 % oder mehr festgestellt wurde. Dieser sorgfältige Prozess resultierte in einem sauberen und zuverlässigen Datensatz von 298 einzigartigen Bewertungen.

Mit Hilfe der natürlichen Sprachverarbeitung (NLP) extrahierte das Team nuancierte Einsichten aus den gesammelten Bewertungen. Eine erste Sentimentanalyse ergab eine überwiegend positive Stimmung unter den Kunden, ein vielversprechender Indikator für die Aufnahme des Produkts. Die Analyse ging tiefer und identifizierte spezifische Vor- und Nachteile, die in den Bewertungen erwähnt wurden.

Um die Rohdaten aufzupolieren und bedeutungsvolle Themen herauszudestillieren, setzte das Team grosse Sprachmodelle (LLMs) ein. Diese anspruchsvolle Analyse generierte 13 Schlüsselthemen und bot ein umfassendes Verständnis der Kundenpräferenzen sowie Einblicke in die Auswirkungen des Produkts.

Für diejenigen, die ein ausgeprägtes Interesse an den technischen Details hinter diesem innovativen Ansatz haben, bietet das folgende Unterkapitel einen tieferen Einblick in die Methoden und Technologien, die vom Team eingesetzt wurden. Dieses Projekt demonstriert nicht nur das Potenzial der Kombination fortschrittlicher Datenanalysetechniken, sondern unterstreicht auch Nestlés Engagement, Kundenbedürfnisse durch Innovation zu verstehen und zu erfüllen.

Abbildung 1: Themencluster-Visualisierung, die Themen mit zugehörigen Dokumenten zeigt

Die Analysepipeline besteht aus einer Mischung aus dem GPT 3.5-Modell und BERTopic. BERTopic nutzt Transformatoren und c-TF-IDF, um dichte Cluster ähnlicher Dokumente zu erzeugen und die Interpretation von Themen zu erleichtern, indem wichtige Begriffe in ihren Beschreibungen beibehalten werden.

Analyseblöcke:

- Generierung von Stimmungen mit dem GPT 3.5-Modell

- Extrahieren von Vor- und Nachteilen mit dem GPT 3.5-Modell (gpt-3.5-turbo-1106)

- Erstellung reproduzierbarer Themen mit dem BERTopic-Algorithmus.

- Identifizierung von Unterthemen mit dem hierarchischen Clustering von BERTopic.

- Erstellung der endgültigen Namen durch Kombination aller oben genannten Techniken.

Als letzten Schritt erstellte das Team eine Streamlit-App, mit der man seine Ergebnisse erkunden kann:

- Sehe wovon die Kunden schwärmen und wo die Bedenken über verschiedene Plattformen hinweg schwelen.

- Entdecke die Themen, die den Kunden am meisten am Herzen liegen, sowohl positive als auch negative.

- Bist du neugierig auf bestimmte Details? Frag einfach den ChatGPT-gesteuerten Assistenten! Erhalte Beispiele aus dem wirklichen Leben und Einblicke in jedes Thema, das mit den gesammelten Daten zusammenhängt.

- Füge die neuesten Bewertungen hinzu und sehe wie sie zum Gesamtbild beitragen.

Bestsecret's Best Secret - Ein Blick hinter die Fassaden eines Online-Shops

Studenten: Anurag Chowdhury, Faezeh Nejati Hatamian, Tschimegma BataaLaut aktuellen E-Commerce-Statistiken ist für 93 % der Verbraucher das Erscheinungsbild der wichtigste Faktor bei der Kaufentscheidung, was unterstreicht, dass das Kundenerlebnis für den Erfolg von BestSecret entscheidend ist. BestSecret ist eine Online-Shopping-Community, die nur für Mitglieder zugänglich ist und Premium- und Luxusmarken zu exklusiven Preisen anbietet.

Der Schwerpunkt des Projekts lag auf der Klassifizierung aller Produktbilder nach ihrem Typ, wobei das Team Erkenntnisse darüber gewinnen wollte, welche Teile der Bilder die Entscheidung des Klassifizierungsmodells beeinflussen, um die Genauigkeit und den Einblick in bildbasierte Empfehlungen zu verbessern. BestSecret stellte die Produktbilder für 4 verschiedene Kategorien zur Verfügung: Kleidung, Schuhe, Unterwäsche und Taschen. Jede Kategorie ist in fünf Klassen unterteilt. Die Bekleidungskategorie umfasst beispielsweise das Aussehen des Models, Vorder- und Rückansichten, Geisterbilder und gezoomte Details.

Abbildung 1: Daten

Abbildung 2: Ergebnisse

Anschliessend wurde eine Streamlit-App entwickelt, mit der die Leistung des Modells untersucht werden kann und die Metriken wie Genauigkeit, Klassifizierungsberichte, Konfusionsmatrizen und die Anzahl der falsch klassifizierten Bilder für jede Kategorie anzeigt.

Um das Problem der Fehlklassifizierungen zu lösen, implementierte das Team Grad-CAM für die falsch klassifizierten Bilder. Dieses Tool ist von unschätzbarem Wert, da es verdeutlicht, auf welche Bereiche eines Bildes sich ein neuronales Faltungsnetzwerk (CNN) konzentriert, wenn es eine Vorhersage trifft.

Zusammenfassend lässt sich sagen, dass die Umstellung von der manuellen auf die automatische Klassifizierung die Genauigkeit deutlich verbessert hat, und zwar von etwa 90 % auf bis zu 97 %, während gleichzeitig der manuelle Aufwand minimiert werden konnte. Das System wird durch die Integration von End-to-End-Beschriftungsfunktionen weiter verfeinert werden.

Der nächste Schritt besteht darin, generative KI einzusetzen, um aus der Vorderansicht eines Artikels Bilder anderer Ansichten zu erstellen, was die Tür zu fortschrittlicheren und effizienteren Bildverarbeitungsfunktionen öffnet.

AlpineSync: Verbesserung des Skierlebnisses mit Data Science und Maschinellem Lernen

Studenten: Oluwatosin Aderanti, Paul Biesold, Raphael Penayo Schwarz, Sebastian RozoSkifahrer:innen erleben zunehmend, wie ihr Sport durch Daten eine neue Dimension erhält. Der Einsatz modernster Technologien ermöglicht es, einen Wintersporttag durch detaillierte Analysen der unterschiedlichen Aktivitäten zu bereichern.

- Das Unternehmen: Alturos Destinations ist darauf spezialisiert, Digitalisierungsstrategien für die Tourismuslandschaft zu entwickeln. Die bereits bestehende Skiline-App des Unternehmens soll mit Hilfe der AlpineSync bereichert werden.

- Die Aufgabe: Zielsetzung des Projektes ist es, eine Alternative zum manuellen Scannen von Lifttickets bereitzustellen. Dies ist insbesondere dann erforderlich, wenn Scangeräte an den Skiliften nicht verfügbar sind.

- Die Idee: Sensordaten von Mobilgeräten werden mit Hilfe von Algorithmen des maschinellen Lernens analysiert. So werden aus den verschiedenen aufgezeichneten Bewegungsformen in Echtzeit Fahrten mit dem Ski-Lift herausgefiltert und klassifiziert. Langfristig vereinfacht dies beispielsweise den Betrieb von Skiliften, indem Tickets nicht mehr manuell gescannt werden müssen.

- Datenaufzeichnung: Für die Erfassung von Sensor- und Bewegungsdaten werden die Apps Sensor Logger (iOS) und Sensors Toolbox (Android) verwendet. Für das Projekt standen zwölf Aufzeichnungen aus zwei verschiedenen Skigebieten zur Verfügung.

- Datenaufbereitung: Für das Training des AlpineSync-Algorithmus wurden die Daten durch Labeling, Resampling, Outlier Detection und Feature Engineering für Supervised Learning aufbereitet.

- Maschinelles Lernen: Insgesamt hat sich der Random Forest Classifier (RFC) mit Genauigkeits-Scores von über 96% als das geeignetste Modell für die Lift-Erkennung bewährt.

- Nachverarbeitung: In der Nachbereitung der Daten werden die Genauigkeit der Klassifizierung verbessert und Fehler minimiert.

- User Experience: Das Visualisieren und Kartieren von Skilift-Ereignissen sowie automatisierte Statistiken zur Nutzung der Skilifte sind neue Features für eine Weiterentwicklung der Alturos Skiline-App

- Die AlpineSync-App: Die App dient als Plattform zur Visualisierung und Interaktion mit den Ergebnissen des Projektes.

Abbildung 1: AlpineSync App Screenshot

Die Zukunftsvision: Die Integration von Kartierungsfunktionen mit Google Maps APIs und die kontinuierliche Verbesserung der Modelle sind weiterhin zentrale Ziele. Nächste Schritte beinhalten:

- Validierung der Algorithmen mit Datensätzen aus unterschiedlichen geografischen Gebieten

- Validierung der Funktionen mit Live-Dateneingabe

- Verbesserung des Clustering-Algorithmus zur Gruppierung von Liftfahrten basierend auf ihren Ursprungs- und Zielorten

Für diejenigen, die von diesen Geschichten inspiriert sind und ihre eigene Reise in der Datenwissenschaft beginnen möchten, freuen wir uns, unseren bevorstehenden Bootcamp anzukündigen. Erfahre mehr über unser Programm und wie du der nächsten Generation von Datenwissenschafts-Innovatoren beitreten kannst auf Constructor Academy.